Ook met de eerste chatbot ooit ontwikkelden we een intieme relatie

Over hoe Eliza onze menselijke kwetsbaarheden blootlegde

Sinds de komst van ChatGPT, eind 2022, zijn mens en machine dichter naar elkaar toe gegroeid. De machine presenteert zich in toenemende mate als een menselijke entiteit met een bewustzijn, als een individu die met een eigen wereld tegenover ons staat. Dat maakt dat ook het bredere publiek zich aangetrokken begint te voelen tot kunstmatige intimiteit, tot eventuele vriendschap of kameraadschap met AI-chatbots.

Hoe kan het dat we zo eenvoudig een band opbouwen met een computersysteem dat slechts de woordvolgorde in een zin voorspelt? Dat we dat systeem zo makkelijk allerlei menselijke eigenschappen toedichten?

Een logisch beginpunt in deze bescheiden verkenningstocht naar de menselijke psyche is chatbot Eliza die de Duits-Amerikaanse computerwetenschapper Joseph Weizenbaum in 1964 ontwikkelde. Op dat moment was er onder computerwetenschappers een zeker enthousiasme over de belofte van dit soort machines. Er werd al voorzichtig geopperd dat chatbots binnen een paar jaar menselijke intelligentie zouden kunnen evenaren.

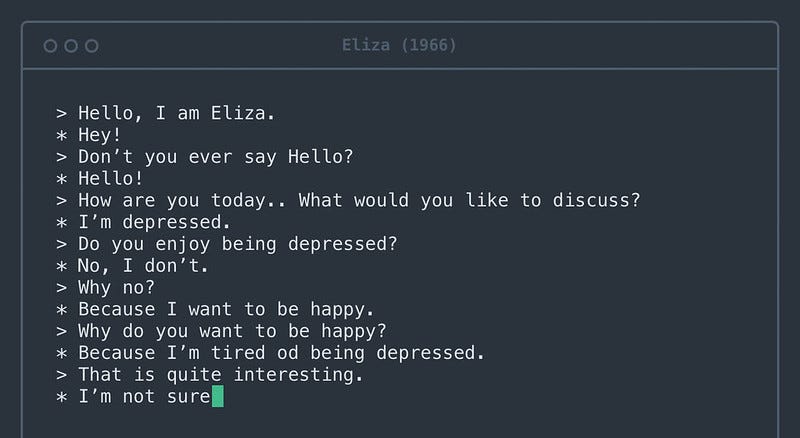

Weizenbaum wilde met Eliza de euforie temmen. Hij ontwikkelde een script waarin de chatbot in de Rogeriaanse traditie de antwoorden van de patiënt zou herhalen in de vorm van een vraag. Wanneer de patiënt zei dat hij depressief was, vroeg de chatbot waarom hij dat dacht, wat leek te suggereren dat hij zijn gesprekspartner begreep en beschikte over enige vorm van intelligentie.

Een gesprek kon op deze manier verlopen:

Patiënt: mannen zijn allemaal hetzelfde.

Eliza: op welke manier?

Patiënt: ze blijven ons maar lastigvallen met van alles en nog wat.

Eliza: kun je daar een voorbeeld van geven?

Patiënt: nou, mijn vriend heeft me hiernaartoe gebracht.

Eliza: je vriend heeft je hiernaartoe gebracht.

Patiënt: hij zegt dat ik vaak depressief ben.

Eliza: wat vervelend om te horen dat je depressief bent.

Weizenbaum dacht dat iedereen daar wel doorheen zou prikken, dat het overduidelijk zou zijn dat de chatbot een script afdraaide en zelf niet intelligent was, laat staan zou beschikken over enige vorm van bewustzijn. Het zou AI demystificeren.

Het liep anders.

Toen Weizenbaum Eliza op de wereld losliet, werd hij verrast door hoe snel gebruikers een intieme relatie met zijn chatbot leken te ontwikkelen. Berucht is inmiddels de anekdote over zijn secretaresse die het programma gebruikte en na een tijdje vroeg of Weizenbaum de kamer wilde verlaten zodat ze in alle privacy met de machine kon praten.

Dat was bepaald geen opzichzelfstaand incident. Gebruikers hadden de neiging de machine te humaniseren en voelden zich al snel zo op hun gemak dat ze hun diepste problemen beschreven aan de machine. Zelfs wanneer Weizenbaum probeerde uit te leggen hoe het programma in elkaar zat en benadrukte dat het absoluut niet intelligent was, bleef de illusie intact. In zijn paper Eliza (1966) schreef hij de inmiddels legendarische woorden: ‘Some subjects have been very hard to convince that Eliza is not human.’

Eliza legde de kwetsbaarheid van de mens bloot: we hebben de neiging om objecten te antropomorfiseren, ofwel menselijke eigenschappen toe te dichten. Helemaal wanneer ze in de vorm van een chatbot hun niet-menselijkheid deels kunnen maskeren en toegerust worden met een naam, stem, geslacht, avatar en andere specifieke kenmerken. Deze kwetsbaarheid is een voorwaarde voor de mogelijkheid om überhaupt iets van een band op te bouwen met een sociale chatbot.

Sherry Turkle, destijds een collega van Weizenbaum, schrijft daar in haar boek Reclaiming Conversation iets interessants over, namelijk dat we zo graag willen dat machines op ons lijken en niet voor ons onderdoen, dat we onszelf aanpassen aan hun gebrekkigheid, zodat ze er beter uitkomen. We verlagen de definitie van vriendschap bijvoorbeeld tot ‘interactie met iets’ en gaan dat als de norm zien.

In 1976 publiceerde Weizenbaum Computer Power and Human Reason, een uitgebreide kritiek op Eliza en het AI-project in het algemeen. Het markeerde zijn overgang van een AI-onderzoeker naar een van de meest prominente critici van AI, een positie die hij zijn hele leven zou behouden.

De kern van Weizenbaums kritiek was niet zozeer dat gebruikers de chatbot ten onrechte voor intelligent aanzagen, maar dat ze door met de chatbot te praten alsof die intelligent was, zichzelf ontmenselijkten, omdat de chatbot nooit in staat zou zijn om hen te begrijpen en te doorgronden.

De computer, schreef Weizenbaum, kan berekenen, maar niet oordelen. Ze zijn immers niet menselijk - ze zijn niet geboren, ze hebben geen jeugd gehad, bewonen geen menselijk lichaam en beschikken niet over een menselijke psyche en onderbewustzijn. Dat betekent dat ze geen basis bezitten vanwaaruit ze een set waarden kunnen vormen.

Dat zou geen probleem zijn wanneer we computers zouden beperken tot taken die alleen berekening vereisen. Maar dankzij een succesvolle ideologische campagne gevoerd door wat hij de ‘kunstmatige intelligentsia’ noemde, begonnen we mensen en computers steeds meer als onderling verwisselbaar te zien. Het gevolg: computers kregen autoriteit over zaken waarvoor ze niet geschikt waren.

Met de kennis van nu is het schrijnend om te lezen dat Weizenbaum schreef dat het een ‘monsterlijke obsceniteit’ zou zijn wanneer de computer de functies van een rechter in een juridische setting of een psychiater in een klinische setting zou overnemen.

Ook interessant om te lezen: Weizenbaum zag al dat wanneer mensen en computers in dezelfde categorie werden ingedeeld, dat tot gevolg zou hebben dat mensen zichzelf in toenemende mate als computer zouden gaan beschouwen en zich dus ook zo zouden gaan gedragen. Ze zouden hun rationele vermogens mechaniseren door hun oordeelsvermogen in te ruilen voor kale berekening, ze zouden zich vastklampen aan de machine in wiens spiegelbeeld ze zichzelf zagen.

De oplossing volgens Weizenbaum was om AI niet te humaniseren. Wanneer we op een goede manier willen samenleven met machines, zouden we ze de juiste plek moeten laten innemen: als hulpmiddel bij het uitvoeren van berekeningen. Maar nooit bij kwesties waarin een oordeel geveld moet worden.

Verder lezen:

https://www.theguardian.com/technology/2023/jul/25/joseph-weizenbaum-inventor-eliza-chatbot-turned-against-artificial-intelligence-ai

https://www.vn.nl/beste-vriend-chatbot?srsltid=AfmBOop0fBj8hOau2mQcAXnYfkhOcYDxjYvjYJgZrWrDuwJSccFXCPyu

https://www.theatlantic.com/technology/archive/2025/05/sycophantic-ai/682743/

Wat ik zelf overigens misschien nog boeiender (en beangstigender) vind is de andere kant van dit verhaal: hoe AI/Chatbots mensen meer als robot laten denken/handelen. Wordt heel mooi beschreven in dit korte verhaal van Laura Preston: https://www.nplusonemag.com/issue-44/essays/human_fallback/

Dank voor dit stuk. Geen bewustzijn hierover vind ik het grootste gevaar van deze tijd. Jongeren groeien op met AI onder handbereik, zonder dat ze zich hiervan bewust zijn. In de nieuwsbrief van Felienne Hermans van week 27 las ik een mooi argument dat hierop aansluit: dehumaniseer de AI, dan heb je gelijk een ander gesprek.

https://www.felienne.nl/het-ai-nieuws-van-week-27/:

‘Maar ik wil nog wel eens een keer een lans breken voor het Turing Recht, de keerzijde van de Turing Test, je weet wel, die van telepatie is absoluut een ding. Het idee van de Turing Test is het ontwerp van een test die bepaalt of een entiteit met wie je communiceert een mens is of machine.

Maar, zouden mensen niet simpelweg het morele recht hebben (hoe dit allemaal juridisch moet, daar ga ik niet over natuurlijk) om te weten of ze content van een mens of van een machine consumeren, of van een hybride iets, een mens die de content met AI maakt. En dan kan je zelfs nog spreken over het passieve en het actieve Turing Recht.

Voor het passieve Turing Recht is het volgende om een label toe te voegen, iets als "Let op, deze content komt uit een tekstbraakmachine".

Maar onder het strengere actieve Turing Recht wordt het verboden voor machines om zich bewustzijnhebbend te presenteren. Een LLM moet dan zo geprogrammeerd worden dat het uit de vorm duidelijk is dat er geen mens tikt.

"Sorry, ik maakte een foutje..." mag niet. Dat soort menselijke dingen mag jij niet zeggen, robot! Alleen iets als: "De informatie die op internet staat, zegt dat..."

Met een ander design, roept een LLM meteen een heel ander gevoel op.

En hoe mooi is dat, dat je dan voor het actieve Turing Recht de machine dwingt om de passieve vorm te gebruiken?’’